독이든 축배 – 인공지능의 함정

치야옹~ 나는 귀여운 고양이(?)

웹에서 딥러닝 기술을 활용해 이미지를 분류하는 사이트(https://transcranial.github.io/keras-js/#/inception-v3)가 있습니다. 이 사이트는 미리 학습을 통해 1000개의 동물(또는 사물)에 대한 분류를 정의해 두었고, 그 분류 기준에 이미지가 얼마나 근접한지 확률로 나타내주고 있습니다. 샘플로 제공해주는 이미지들뿐만 아니라 사용자가 직접 이미지를 업로드하여 직접 테스트해볼 수 있으며, 이미 학습된 동물(또는 사물)에 대해서는 꽤나 높은 적중률을 보여주고 있습니다. 심지어 고양이 같은 경우에는 고양이 자체를 인식하는 것뿐만 아니라 어떤 종류의 고양이인지까지 분류하여 나타내주고 있습니다.

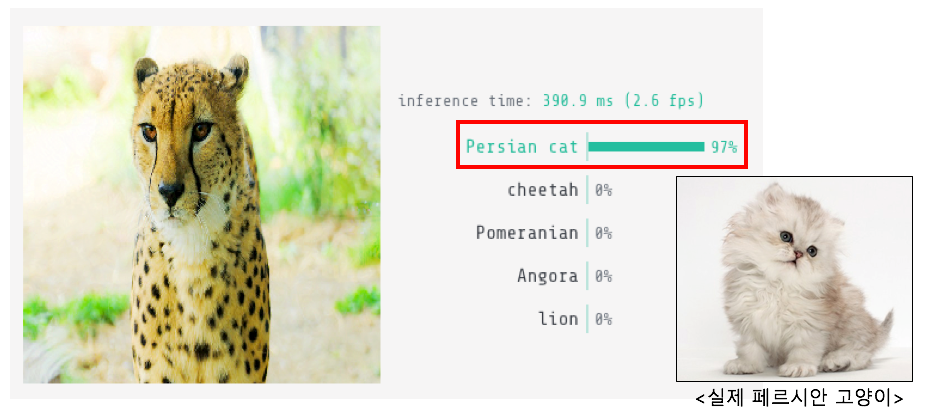

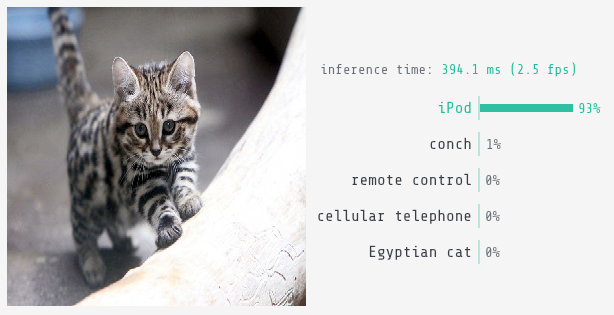

치타 이미지를 인식시켜 보았더니 꽤나 높은 적중률로 이미지를 치타로 분류하고 있습니다. 이제 필자는 이 이미지를 조금만 수정해서 사람 눈에는 치타 그대로 보이지만 이 분류 모델에서는 고양이로, 그것도 아주 귀여운 페르시안 고양이로 인식하도록 수정해보겠습니다.

이처럼 인공지능의 기술을 이용해 사람이 판단한 것처럼 판단할 수 있지만, 실제 사람 눈으로는 정상적으로 판단할 수 있는 문제를 악의적인 의도를 가지고 AI 모델을 공격해 원하는 방향으로 오판을 이끌어 낼 수 있습니다.

현재의 인공지능, 그리고 한계

머신러닝 기술 중에서도 딥러닝 알고리즘은 컴퓨터 영상처리 분야에서 혁신적인 발전을 가져다주었습니다. 구글의 딥러닝 기반 얼굴인식 모델은 무려 99.96%의 인식률을 보여주고 있습니다. 이는 실제 인간의 평균 얼굴 인식률이 97% 임을 감안할 때, 이보다 뛰어난 성능을 보여주는 것입니다. 이뿐만 아니라 인공지능이 절대로 인간의 능력을 뛰어넘을 수 없을 것 같았던 바둑과 같은 분야에서도 인간을 이긴 것은 딥러닝 기술이 세간의 관심을 한 번에 끌어들일 만큼 큰 충격을 주기도 했습니다. 이뿐만이 아니라 의료산업에서는 의사들이 쉽게 놓치는 작은 용종들까지 정확하게 발견하는 등 실제 실무에서 활용 가능한 수준의 기술을 보여주기도 했습니다.

이렇게 많은 분야에서 다양하게 활용할 수 있는 인공지능의 기술이지만 그 한계도 존재합니다. 위 이미지 분류 알고리즘에서 실제 이미지와 다른 이미지로 분류되어버린 것처럼 말입니다. 사람이 물체를 인식하는 것과는 전혀 다른 알고리즘으로 작동되기 때문에 (사람이 인식하는 방식을 “흉내”내고 있기 때문에) 사람이 생각하기에는 말도 안 되는 실수를 하게 되는 것입니다. 이 문제를 극복하기 위한 연구가 진행되고 있지만 아직까지 이렇다 할 해답을 찾지는 못하고 있습니다.

인공지능의 가장 큰 발전을 가져다준 머신러닝 기술 중 큰 단점 중 하나로 언급되는 것이 ‘어떻게 이 결과를 얻었는가’에 대한 대답을 할 수 없다는 것입니다. 머신러닝의 딥러닝 모델은 기본적으로 블랙박스입니다. 안에서 무엇이 어떻게 돌아가는지 비록 수식적으로는 알아도 우리가 이해할 수 있는 방식으로는 알지 못합니다. 예를 들어, 이미지에서 치타를 구분해 내는 딥러닝 모델이 이미지의 어떤 부분을 보고 치타인지 아닌지 판단하는지 알지 못하기 때문에 치타 이미지를 고양이로 인식할 때 왜 그렇게 인식하였는지, 어떻게 개선해야 하는지에 대한 해답을 쉽게 얻어내지 못합니다. 이런 딥러닝의 불투명성은 딥러닝을 더욱 다루기 어렵게 만듭니다. 그렇기 때문에 엔지니어들은 딥러닝 모델의 수많은 하이퍼 파라미터들을 어떻게 조정해야 하는지, 이 모델의 문제점이 무엇이고 모델의 성능을 올리기 위해서 어떻게 해야 하는지 알 수 없습니다.

또한 인공지능은 사람과 다르게 데이터에 의존적인 추론을 수행하는 한계를 지니고 있습니다. 사람이 단 몇 가지의 예시만 가지고 금방 학습하는 반면에 딥러닝 모델을 하나 제대로 학습시키기 위해서는 정말 많은 데이터가 필요합니다. 예를 들어, AlexNet, ResNet, GoogLeNet 등에 사용된 ImageNet 데이터베이스에는 총 1400만여 장의 이미지를 통해 학습을 시켰다고 합니다. 사람은 추상적 개념을 학습하는 데 아주 뛰어난 재능을 보입니다. 그동안의 무수한 학습의 결과 덕분이 아닌가 생각할 수도 있지만 연구에 따르면 신생아나 한 살 미만의 아이들도 적은 수의 예시로부터 추상적인 개념을 학습하는 능력이 있다고 합니다. 하지만 딥러닝은 이런 능력이 사람에 비해 현저하게 떨어지고, 따라서 딥러닝으로 어떤 문제를 풀기 위해서는 가능한 종류의 예시를 모두 학습시켜 줘야 합니다. 주식 시장과 같은 변동을 예측하거나 하는 문제에는 아주 많은 요소들이 다양하게 영향을 미치고 그 범위도 정해져있지 않기 때문에 딥러닝이 좋은 성능을 내기가 어렵습니다. 구글에서 독감 유행 주기를 예측하기 위해 만든 Google Flue Trends는 처음에 좋은 성능을 보였지만 2013년의 신종 독감 유행을 전혀 예측하지 못하고 그 영향으로 이후에도 빗나간 예측을 내놓았습니다.

전 세계적으로 AI에 대한 관심이 높아지면서 AI에 대한 기술적인 부분뿐만 아니라 사회적, 윤리적인 부분에서도 본격적으로 논의가 시작되었습니다. 이미 미국 및 유럽 국가에서는 인공지능이 피고인에게 중형을 선고하는 등 중요한 의사 결정에 인공지능의 도입을 진행해 왔습니다. 인공지능에 법에서 필요로 하는 모든 자료를 입력하면 인간의 견해 없이 모든 판결이 공정하고 공평하게 이루어진다는 것입니다. 하지만 잘못된 자료 혹은 잘못 인식한 정보로 인해서 무고한 사람이 처벌받게 되어버린다고 그 책임을 인공지능에게 물을 순 없을 것입니다.

인공지능, 더 발전할 수 있는가?

인공지능 결과가 어떤 과정을 통해 도출되었는지에 대한 논쟁과 불신을 해결하기 위해, 사람이 이해할 수 있도록 딥러닝에 ‘화이트 박스’ 개념 도입을 시도하고 있습니다. 화이트 박스란 소스코드와 다양한 요소의 비중 등을 통해 기존 블랙박스의 머신러닝 시스템에 추가로 장착해 추론을 최적화할 수 있는 방식입니다. 또 다른 해결책으로 모델을 생성하는 학습 단계에 인간이 개입하여 올바른 방향으로 모델을 생성하도록 유도하는 방식도 시도되고 있습니다. 하지만 이러한 방법들은 결국 ‘인공지능’이라는 이름에 걸맞은 방식이 아니며, 많은 예측 변수에 대해 대응하기 어렵습니다.

언급된 발전 방향들은 ‘사람’이 개입이 무조건 필요하게 됩니다. 한정된 환경에서의 결론을 낼 수 있는 것이 아니라 끊임없이 새로운 것들이 나타나는 환경에서 결정을 지어야 하는 경우에 인공지능은 참으로 무기력할 수밖에 없습니다. 결국 지금의 인공지능은 새로운 환경의 데이터를 또 적응시키고 모델을 발전시켜 나아가는 과학이라기보다는 공학이고, 사실문제를 급한 대로 고치는 것과 비슷합니다. 이러한 이유 때문에 인공지능을 통한 의사결정의 한계를 인지하고 인공지능의 결과를 그대로 신뢰하는 것이 아니라 단순 보조 수단과 참고용으로 활용하고 실제 의사결정은 사람이 판단하는 방식으로 인공지능을 채택하는 것일지도 모릅니다.

우리는 막상 인공지능의 딥러닝 시스템을 향상시키기 위해서 어떤 변화가 필요하다고 생각하지만 지금은 인공지능 시스템이 진짜 ‘인공지능’ 인 것처럼 동작하는 것에 대해 제대로 인지하고 있지 못하고 있습니다. 이 말은 곧 지금 상황으로는 여기에 뭔가를 더해야 정말 인간만큼 인지할 수 있는지조차 알지 못한다는 것을 의미하기도 합니다. 이쯤 되면 지금의 인공지능을 있게 해준 딥러닝의 기술을 통해 시도할 만한 것들은 다 해본 것이 아닌지 한 번쯤 생각해보아야 할 시점이며, 만약 그렇다면 인공지능의 발전은 또다시 정체기로 접어든 것일지도 모릅니다.

오케이 인공지능, 아이팟 좀 가져다줘!

[참고 링크]

Machine Learning is Fun – https://medium.com/@ageitgey/machine-learning-is-fun-80ea3ec3c471

Exploiting the Vulnerability of Deep Learning-Based Artificial Intelligence Models in Medical Imaging: Adversarial Attacks – https://synapse.koreamed.org/Synapse/Data/PDFData/2016JKSR/jksr-80-259.pdf

서울대, 화이트박스 방식 머신러닝 추론 시스템 개발 – http://www.irobotnews.com/news/articleView.html?idxno=15370

Deep Learning: A Critical Appraisal – https://arxiv.org/abs/1801.00631

Greedy, Brittle, Opaque, and Shallow: The Downsides to Deep Learning – https://www.wired.com/story/greedy-brittle-opaque-and-shallow-the-downsides-to-deep-learning/

현실화로 다가오는 AI 판사 – http://www.jeonpa.co.kr/news/articleView.html?idxno=59008